Слова-неологізми - "фейк", "постправда" і зовсім свіже "дипфейк" - вказують лише на вдосконалення технологій, а зовсім не на новизну явища.

Уявлення про те, що можна змінити хід історії ретушуванням фото або обрізуванням відео, були й у політиків минулого. Наприклад, у часи Радянського Союзу з фотографій вирізали невгодних Сталіну. Так пропадали Микола Єжов, Михайло Калінін, Григорій Петровський та інші колишні соратники. А вже після смерті диктатора 1953 року й доповіді Микити Хрущова "Про культ особи та його наслідки" почали зникати й викреслюватися цензорами і фотографії самого Сталіна.

У маніпуляціях із зображеннями й відеопотоком немає нічого нового. Погляньмо на кінематограф. 1994 року режисер Роберт Земекіс поміщає Форреста Гампа в історичний кадр із Джоном Кеннеді. Герой з'являється в телехроніці з господарем Білого дому і тисне президентові руку.

Або інші приклади: актор Пол Вокер загинув в автокатастрофі 2013 року, коли ще не завершилося фільмування блокбастера "Форсаж-7" з його участю. Щоб створити сцену з Вокером, автори фільму використали цифрову копію обличчя актора. У п'ятому сезоні "Гри престолів" оголена Серсея Ланністер проходить через Королівську гавань. Але насправді акторку замінила 27-річна модель Ребекка Ван Клів. Для цього окремо зняли емоції на обличчі Серсеї й окремо прохід оголеної Ребекки, а потім поєднали картинки.

Із кожним роком технології фальсифікації відеозображень удосконалюються. Замість особистого оперування фотошопом або відеоредактором сучасні дизайнери й програмісти для створення несправжнього відео з фотографій тренують нейромережі. Сьогодні всі охочі можуть створювати відеопідробки, використовуючи відповідний софт. Наприклад, мобільний додаток Pinscreen пропонує "зробити селфі й автоматично згенерувати 3D-аватар за лічені секунди" або "вивести щільну тривимірну сітку вашого обличчя, тривимірну позу голови й орієнтири на обличчі". Доступна безплатна програма Fakeapp, яка дозволяє генерувати реалістичні відео з заміною облич.

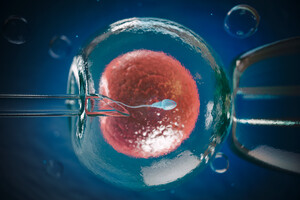

Deepfake - технологія, заснована на штучному інтелекті, використовується для виробництва або зміни відеоконтенту, яка цілком правдоподібно зображує те, чого насправді не було. В Україні вигадали власний переклад цього терміна - "лицедурство", тобто щось середнє між лицедієм-удавальником і дурістю-легковажністю.

Якщо використовувати дипфейк як розвагу, безневинний розіграш або оригінальне привітання нібито від відомої особистості, то в цьому немає нічого поганого. Водночас фейкові відео можуть завдати серйозної шкоди репутації відомих (і не тільки) людей, істотно вплинути на симпатії електорату. Уже можна бачити, як на фальшивих відео безглуздо й незграбно виглядають Барак Обама, Ангела Меркель, Дональд Трамп, а відомі актори й моделі в підробках несподівано "рекламують фалоімітатори" або "беруть участь у сексуальних оргіях".

Крім відео підробити можна й голос. Наприклад, для умовного Photoshop for audio потрібен 20-хвилинний аудіозапис розмови. Штучний інтелект аналізує файл, з'ясовує, як людина говорить, і вчиться імітувати стиль мови й тембр голосу. Потім достатньо просто надрукувати або вставити текст - і програма скаже голосом потрібної людини будь-які слова. Такі додатки популярні, їх кількість зростає: наприклад, програма WaveNets здатна генерувати мову, що імітує будь-який людський голос.

Поява дипфейку відкриває для маніпуляторів можливості без надмірних зусиль створювати суперечливі заяви будь-якого політика або публічної персони, а системи безпеки, засновані на розпізнаванні голосу, втратять свою актуальність. Телефонні розмови вже зараз можна підробити за дві-три хвилин, і ніхто не буде точно упевнений, що говорите саме ви. З такими темпами розвитку технологій можна буде обманювати судову експертизу, фальсифікувати документи, історичні свідчення.

Уявімо, що через сто років дослідники аналізуватимуть ситуацію в Україні і знайдуть відеозапис студії одного з київських телеканалів, де видно, що на ток-шоу "був присутній" екс-прем'єр-міністр Микола Азаров, котрий утік з України 2014 року. Переглянувши запис, дослідник вирішить, що в березні 2019-го Азаров уже повернувся в столицю України, і зазначить цей факт у своєму історичному матеріалі. Адже відео цілком реалістичне, в ньому ніщо не вказує на те, що насправді Азаров "був присутній" у студії лише віртуально. На заставці був напис: "Микола Азаров у студії нашого телеканалу", і лише після суспільного резонансу з приводу фальсифікації факту присутності чиновника-втікача в студії телеканал розіслав виправдання: "У нашій студії Азаров перебував за допомогою системи доповненої реальності й трекінгу для введення віртуального об'єкта в реальну студію". Простіше кажучи, Азаров був не в Києві, а сидів у невідомому місці на тлі хромакей, при цьому ні редакція, ні сам колишній прем'єр не повідомили про реальне місце перебування, а канал зображував його присутність у київській студії.

Використання нових технологій підробки відео трансформує зміст доказів у журналістиці, політичних комунікаціях, сферах кримінального судочинства і національної безпеки. Безумовно, виявити фальшивку можна, але річ у тому, що підробки нового типу з'являються раніше, ніж алгоритми їх розпізнавання. Саме тому ще більше зростає роль медіа у процесі перевірки вхідної інформації.

В українську політику штучний інтелект поки що не проник. Але як висловилася одна з головних редакторок популярного в країні медіа: "У наших поки що руки з нижніх плечей, але вони швидко навчаться". Як навчилися, наприклад, створювати нішеві інформаційні канали, що стали "фішкою" нинішньої виборчої кампанії: в кожного штабу свій телеканал, який просуває в суспільний порядок денний потрібні повідомлення, що корегують розповіді й сприйняття реальності в Україні. Один з політиків, котрий хотів відкрити ще один канал, скаржився, що не зміг цього зробити, бо: "Усі фахівці на ринку зайняті, і ми стикнулися з кадровим дефіцитом". Тобто попит на телевізійне корегування реальності такий великий, що вільних професіоналів уже немає.

Навчилися штаби й таргетувати рекламу в соціальних мережах. В останні дні березня 2019 року, перед виборами президента України, вартість однієї взаємодії з роликами на YouTube коливалася в межах 20 копійок, тоді як у міжвиборчий період при грамотному плануванні й професійній роботі таргетолога вона становить 3-5 копійок. А скандал з розкриттям мільйонних бюджетів, витрачених кандидатами на антирекламу конкурентів у Facebook, змушує замислитися про готовність політиків використовувати будь-які методи для передвиборних маніпуляцій. То невже вони зупиняться перед новими технологіями, що відкривають необмежені можливості для паплюження конкурентів? У це важко віриться.

Межа між реальністю й віртуальним світом стирається швидко, і чимдалі частіше ми вже не можемо довіряти очам і вухам. З моря інформації, що обрушується на нас щодня, мозок найшвидще вихоплює яскраві образи у вигляді картинок і фрагментів відео, формуючи наше сприйняття дійсності й політичні симпатії. Це означає, що технології, спрямовані на викривлення мультимедійного контенту, стають новим видом гонки озброєнь.

Увійти за допомогою Google

Увійти за допомогою Google