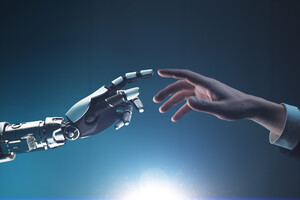

У Давосі продовжуються панельні дискусії у рамках Світового економічного форуму. Багато хто з них присвячений питанням розвитку штучного інтелекту.

У рамках однієї з них, «Всесвіт генеративних моделей, що розширюється», учасники обговорили, чи можливо найближчим часом ще більший розвиток моделей або ж ми вийшли на своєрідне плато.

Один із засновників та генеральний директор Cohere Inc. Ейдан Гомес заявив про те, що розвиток неможливий, якщо дослідники в цій галузі будуть йти тим же шляхом, що і зараз.

«Поки що наша стратегія працювала добре. Побудувати більший суперкомп'ютер, дати більше даних, і ми отримували відмінні результати... Але ми знаємо, що треба робити далі. Нам потрібний онлайн-досвід, нам потрібно взаємодіяти із реальним світом. Як ці моделі розвиваються зараз: у нас є всі ці офлайн-тренування, жодної взаємодії із реальним світом. Ми впроваджуємо їх у продукт, і він статичний, вони не навчаються. І це має змінитись, моделі мають вчитися постійно», - заявив Гомес.

Він також додав, що розроблені нейромережі мають, як і люди, навчатися власними силами, самовдосконалюватися. І головною перешкодою, з якою зіткнулися вчені зараз, є доступ до даних, які дозволять зробити моделі розумнішими, ніж вони є.

«До цього ви могли зупинити будь-кого на вулиці та попросити його навчити модель. І це покращило б її якість. Але вони стають справді розумними. Вже не можна підійти до простого перехожого. Потрібно звати магістра математики чи студента-біолога. А потім – доктора наук. А потім когось? Людство та його знання – це верхня межа для існуючої стратегії. І ми маємо вийти за ці рамки», - заявив Гомес.

CEO The Atlantic Ніколас Томпсон розвинув ідею Гомеса, припустивши, що надалі це призведе до того, що нейромережі навчатимуться, спілкуючись одна з одною і створюючи синтетичні дані. У цьому випадку ми не зможемо бути впевнені, що вони не спотворять своє власне бачення.

За словами Гомеса, необхідно розуміти, що нейромережі не продукуватимуть синтетичні дані в закритій коробці, вони повинні взаємодіяти з навколишнім світом, як люди. Висувати гіпотези, перевіряти їх та висувати нові.

Професорка інформатики Стенфордського університету, засновниця та генеральна директорка Insitro Inc Дафна Коллер наголосила, що зараз у нас немає можливості створити повну модель світу, оскільки він дуже складний. Але ми маємо можливість експериментувати і дивитися, що вийде в результаті, це критично важливо для розвитку інтелекту людини.

«Якщо ми хочемо, щоб ці машини розвинулися, ми маємо дати їм можливість експериментувати зі світом. Дати комп'ютерам можливість створювати експерименти, прості чи складні. Це дозволить комп'ютерам дізнатися більше про неймовірну складність цього світу та вийти за межі того, чого людина може їх навчити», - додала вона.

Раніше ізраїльський історик і футуролог Юваль Ной Харарі заявив про те, що для того, щоб штучний інтелект став загрозою для виживання людської цивілізації, він не повинен ні мати свідомості, ні бути здатним керувати об'єктами фізичного світу. Водночас, за словами вченого, ШІ вже зміг «зламати операційну систему людської цивілізації».

Восени Велика Британія, США, ЄС та Китай погодилися, що штучний інтелект є потенційно катастрофічною загрозою для людства, підписавши першу міжнародну декларацію, присвячену цій технології.

Увійти за допомогою Google

Увійти за допомогою Google