Серед зображень розбомблених будинків і зруйнованих вулиць Гази деякі виділялися повним жахом: закривавлені, покинуті немовлята.

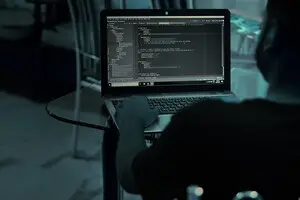

Ці зображення, які переглядалися в Інтернеті мільйони разів з початку війни, є дипфейками, створеними за допомогою штучного інтелекту. Якщо ви уважно придивитеся, ви побачите підказки: дивно скручені пальці, або очі, які мерехтять неприродним світлом — усе це вказує на цифровий обман, пише Associated Press.

Однак обурення, яке вони спровокували, є цілком реальним.

Фотографії війни Ізраїлю та ХАМАС яскраво та болісно проілюстрували потенціал штучного інтелекту як інструменту пропаганди, який використовується для створення реалістичних зображень різанини. Відколи минулого місяця почалася війна, поширені в соціальних мережах цифрові зміни використовувалися для неправдивих заяв про відповідальність за жертви, або для введення в оману людей щодо жорстокості, якої ніколи не було.

Хоча більшість неправдивих тверджень про війну, що поширюються в Інтернеті, були створені без використання штучного інтелекту та надходили з більш звичайних джерел, технологічний прогрес йде все далі, чого не скажеш про контроль над ним.

Це абсолютно очевидно робить потенціал штучного інтелекту ще однією формою зброї і дає уявлення про те, що може відбуватися під час майбутніх конфліктів, виборів та інших великих подій.

«Все буде гірше — набагато гірше — перш ніж стане краще. Зображення, відео та аудіо, створені за допомогою генеративного ШІ — це буде ескалація, якої ви ще не бачили», — вважає Жан-Клод Гольденштайн, генеральний директор CREOpoint, технологічної компанії, розташованої в Сан-Франциско та Парижі, яка використовує ШІ для оцінки обґрунтованості онлайн-претензій.

Компанія створила базу даних найбільш вірусних дипфейків, які з’являлися в Газі.

У деяких випадках за нові видавались фотографії з інших конфліктів чи катастроф. В інших — генеративні програми штучного інтелекту використовувалися для створення зображень з нуля, наприклад зображення дитини, що плаче серед уламків бомбардування, яке стало вірусним у перші дні конфлікту.

Інші приклади створених штучним інтелектом зображень включають відео, на яких зображені нібито ізраїльські ракетні удари, або танки, що котяться через зруйновані квартали, або сім’ї, які прочісують руїни в пошуках тих, хто вижив.

У багатьох випадках підробки розроблені для того, щоб викликати сильну емоційну реакцію, тому містять тіла немовлят, дітей або сімей. У перші криваві дні війни прихильники як Ізраїлю, так і ХАМАС стверджували, що інша сторона вбиває дітей і немовлят. У якості доказів пропонувались дипфейки — зображення плачучих немовлят.

Пропагандисти, які створюють такі образи, вправно працюють із найглибшими імпульсами та тривогами людей, говорить Імран Ахмед, генеральний директор Центру протидії цифровій ненависті, некомерційної організації, яка відстежувала дезінформацію під час війни. Незалежно від того, чи це дипфейк дитини, чи справжній образ немовляти з іншого конфлікту, емоційний вплив на глядача є однаковим.

Що огиднішим є зображення, то більша ймовірність, що користувач запам’ятає його та поділиться ним, мимоволі поширюючи дезінформацію далі.

«Людям прямо зараз кажуть: подивіться на це фото дитини. Дезінформація розроблена, щоб змусити вас залучитися до неї», — пояснює Ахмед.

Подібний оманливий контент, створений ШІ, почав поширюватися після того, як Росія вторглася в Україну в 2022 році. З’явилося одне змінене відео, на якому показано, як президент України Володимир Зеленський наказує українцям здатися. Такі заяви продовжували поширюватися і минулого тижня, показуючи, наскільки стійкою може бути навіть легко розвінчана дезінформація.

Кожен новий конфлікт або сезон виборів надає нові можливості для розповсюджувачів дезінформації продемонструвати останні досягнення ШІ. Через це багато експертів зі штучного інтелекту та політологів попереджають про ризики наступного року, коли в кількох країнах відбудуться масштабні вибори, зокрема в США, Індії, Пакистані, Тайвані, Індонезії та Мексиці.

Ризик того, що штучний інтелект і соціальні мережі можуть бути використані для поширення брехні серед виборців США, викликав занепокоєння законодавців обох партій у Вашингтоні. На нещодавніх слуханнях щодо небезпеки технологій deepfake представник США Джеррі Конноллі, демократ від Вірджинії, заявив, що США повинні інвестувати у фінансування розробки інструментів ШІ, призначених для протидії іншим ШІ.

«Ми як нація повинні це зробити правильно», — сказав Конноллі.

По всьому світу низка технологічних компаній-початківців працюють над новими програмами, які можуть вишуквати дипфейки , прикріплювати до зображень водяні знаки, щоб підтвердити їхнє походження, або сканувати текст, щоб перевірити будь-які підозрілі твердження, які, можливо, зроблені із використанням ШІ.

«Наступною хвилею штучного інтелекту буде: як ми можемо перевірити вміст, який там є. Як ви можете виявити дезінформацію, як ви можете проаналізувати текст, щоб визначити, чи він заслуговує довіри?», — говорить Марія Амелі, співзасновниця Factiverse, норвезької компанії, яка створила програму штучного інтелекту, котра може сканувати вміст на наявність неточностей або упередженості, внесених іншими програмами штучного інтелекту.

Такі програми викликають безпосередній інтерес у викладачів, журналістів, фінансових аналітиків та інших, зацікавлених у викоріненні неправди, плагіату чи шахрайства. Подібні програми розробляються для виявлення підроблених фотографій або відео.

За словами Девіда Доерманна, вченого, який очолює зусилля в Агентстві передових оборонних дослідницьких проектів щодо реагування на створені обробленими ШІ зображеннями загрози національній безпеці, незважаючи на те, що ця технологія є багатообіцяючою, ті, хто використовує штучний інтелект для брехні, часто йдуть на крок попереду.

Доерманн, який зараз є професором в Університеті Баффало, вважає, що ефективна відповідь на політичні та соціальні виклики, пов’язані з дезінформацією штучного інтелекту, потребуватиме як кращих технологій, так і кращих нормативних актів, добровільних галузевих стандартів та значних інвестицій у програми цифрової грамотності, щоб допомогти користувачам Інтернету знайти способи відрізнити правду від фантазії.

«Кожного разу, коли ми випускаємо інструмент, який виявляє це, наші вороги можуть використовувати штучний інтелект, щоб приховати докази. Виявлення та спроба знищити фейковий матеріал більше не є рішенням. Нам потрібно знайти набагато більш масштабний вихід», — говорить Доерманн.

На тлі поширення використання штучного інтелекту, американський словник Merriam-Webster назвав «автентичність» (authentic) словом 2023 року.

Увійти за допомогою Google

Увійти за допомогою Google