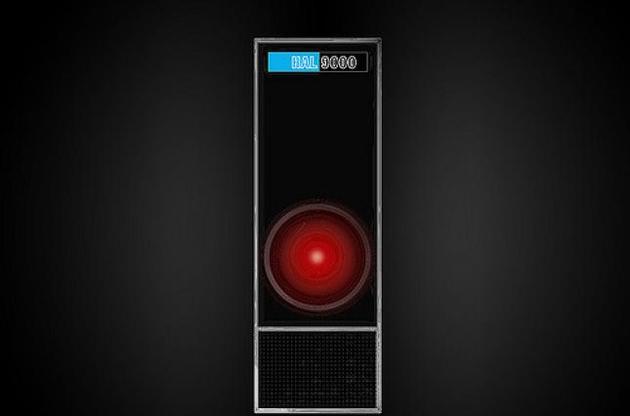

Наукова фантастика пропонує велику кількість прикладів розумних комп'ютерів: від HAL 9000 в фільмі Стенлі Кубрика "2001: Космічна Одіссея" до Eddie в "Автостопом по Галактиці".

Єдина спільна риса у цих вигаданих машин - це схильність помилятися і шкодити героям історій. HAL 9000 вбив більшість членів екіпажу місії на Юпітер. А Eddie, одержимий дрібницями, поставив корабель, за який він відповідає, під загрозу знищення. У обох випадках спроба збудувати щось корисне, призводило до появи монстра.

Успішна наукова фантастика обов'язково повинна грати на реальних надіях чи страхах. В 1960-х і 1970-х роках, коли HAL 9000 і Eddie були вигадані, спроби створити штучний інтелект були безпорадними. Тож страхи і надії були гіпотетичними. Але тепер все змінилося.

Про це пише The Economist. Машинне самонавчання через технологію нейромереж, яка дозволяє машині обробляти великі масиви даних в пошуках закономірностей, сприяє розвитку і поширенню комп'ютерів, які здаються досить розумними. Програми для таких машин варіюються від конвертації людського мовлення в текст до виявлення ранніх ознак розвитку сліпоти. Штучний інтелект тепер веде контроль за якістю на заводах і керує системи охолодження дата-центрів. Уряди сподіваються, що він допоможе виявляти терористичну пропаганду і усувати її з інтернету. Крім того, штучний інтелект займає центральну роль в розробці автономних автомобілів.

З 10 найбільш дорогих компаній у світі 7 кажуть, що планують інтегрувати в свої операції штучний інтелект, який базується на машинному самонавчанні. Тож розумні машини сьогодні дуже близькі до тих, які були описані в науковій фантастиці. Їм, безумовно, бракує усвідомленої мотивації, яка характерна більшості вигаданих аналогів. Але вони все одно породжують страхи і надії, які стосуються сьогодення, а не невизначеного майбутнього. Тому багато людей бояться, що сучасний штучний інтелект теж може перетворитися на монстра. Але цей страх пов'язаний не стільки з тим, що прилади припинять коритися і виконувати інструкції, як з тим, що вони якраз будуть їх виконувати, але в якийсь незбагненний спосіб.

Причина появи такого страху в тому, що програми самонавчання передбачають навчання через зміну своїх "електронних нутрощів" відповідно до закономірностей, які вони виявили в даних. Фактично вони повторюються те, як, на думку вчених, людський мозок вчиться. Сили зв'язків між бітами змінюються в комп'ютерному коді, який розроблений поводитися так, як нейрони.

Таким чином, навіть розробник нейронної мережі не знає точно, як вона працює після проходження навчання. І як вона саме щось вчила. Дозволити таким машинам керувати критично важливою інфраструктурою чи приймати рішення у медицині означає довірити життя людей шматку обладнання, яке не відомо як насправді працює.

Втім, якщо штучний інтелект зможе якось пояснити, що і чому він робить, довіра до нього зросте. А отже він зможе бути більш корисним. До того ж, якщо щось піде не так, власні пояснення штучного інтелекту дозволять краще і швидше провести розслідування помилки.

Раніше Ілон Маск заявив про те, що штучний інтелект є найбільшою загрозою, з якою людство може зіткнутися як цивілізація і закликав до жорсткого державного регулювання розвитку штучного інтелекту.