Слова-неологизмы: "фейк", "постправда" и совсем свежее - "дипфейк" указывают лишь на совершенствование технологий, а вовсе не на новизну явления.

Представления о том, что можно изменить ход истории путем ретуширования фото или обрезки видео были и у политиков прошлого. Например, во времена Советского Союза из фотографий "вырезали" неугодных Сталину. Так пропадали Николай Ежов, Михаил Калинин, Григорий Петровский и другие бывшие соратники. А уже после смерти диктатора в 1953 году и доклада Никиты Хрущева "О культе личности и его последствиях" стали исчезать и вычеркиваться цензорами и фотографии самого Сталина.

В манипуляциях с изображениями и видеопотоком нет ничего нового. Посмотрим на кинематограф. В 1994 году режиссер Роберт Земекис помещает Форреста Гампа в исторический кадр с Джоном Кеннеди. Герой появляется в телехронике с хозяином Белого дома и жмет руку президенту.

Или другие примеры: актер Пол Вокер погиб в автокатастрофе в 2013 году, когда еще не закончились съемки блокбастера "Форсаж-7" с его участием. Чтобы создать сцену с Вокером, авторы фильма использовали цифровую копию лица актера. В пятом сезоне "Игры престолов" обнаженная Серсея Ланнистер проходит через Королевскую гавань. Но на самом деле актрису заменила 27-летняя модель Ребекка Ван Клив. Для этого отдельно сняли эмоции на лице Серсеи и отдельно проход обнаженной Ребекки, а затем совместили картинки.

С каждым годом технологии фальсификации видеоизображений совершенствуются. Вместо личного оперирования фотошопом или видеоредактором, современные дизайнеры и программисты для создания ненастоящего видео из фотографий тренируют нейросети. Сегодня все желающие могут создавать видеоподделки, используя соответствующий софт. Например, мобильное приложение Pinscreen предлагает "сделать селфи и автоматически сгенерировать 3D-аватар за считанные секунды" или "вывести плотную трехмерную сетку вашего лица, трехмерную позу головы и ориентиры на лице". Доступна бесплатная программа FakeApp, позволяющая генерировать реалистичные видео с заменой лиц.

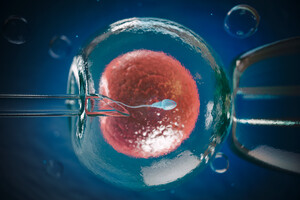

Deepfake - технология, основанная на искусственном интеллекте используется для производства или изменения видеоконтента, вполне правдоподобно изображающего то, чего на самом деле не было. В Украине придумали собственный перевод этого термина - "лицедурство", то есть нечто среднее между лицедеем-притворщиком и дуростью-легкомысленностью.

Если использовать дипфейк в качестве развлечения, безобидного розыгрыша или оригинального поздравления якобы от известной личности, в этом нет ничего предосудительного. В то же время фейковые видео могут нанести серьезный вред репутации известных (и не только) людей, существенно повлиять на симпатии электората. Уже можно лицезреть, как на фальшивых видео нелепо выглядят Барак Обама, Ангела Меркель, Дональд Трамп, а известные актеры и модели в подделках вдруг "рекламируют фаллоимитаторы" или "участвуют в сексуальных оргиях".

Кроме видео подделать можно и голос. Например, для условного Photoshop for audio требуется 20-минутная аудиозапись разговора. Искусственный интеллект анализирует файл, выясняет, как человек говорит, и учится имитировать стиль речи и тембр голоса. Затем достаточно просто напечатать или вставить текст - и программа проговорит голосом нужного человека любые слова. Такие приложения пользуются популярностью, их количество растет: например, программа WaveNets способна генерировать речь, имитирующую любой человеческий голос.

Появление дипфейка открывает манипуляторам возможности без лишних усилий создавать противоречивые заявления любого политика или публичной персоны, а системы безопасности, основанные на распознавании голоса, станут бесполезными. Телефонные разговоры уже сейчас можно подделать за пару минут, и никто не будет точно уверен, что говорите именно вы. С такими темпами развития технологий можно будет обманывать судебную экспертизу, создавать поддельные документы, исторические свидетельства.

Представим, что через 100 лет исследователи будут анализировать ситуацию в Украине и обнаружат видеозапись студии одного из киевских телеканалов, где видно, что на ток-шоу "присутствовал" сбежавший в 2014 году из Украины экс-премьер-министр Николай Азаров. Просмотрев запись, исследователь решит, что в марте 2019 года Азаров уже вернулся в столицу Украины, и отметит этот факт в своем историческом материале. Ведь видео вполне реалистично, в нем ничто не указывает, что на самом деле Азаров "присутствовал" в студии лишь виртуально. На заставке была надпись: "Николай Азаров в студии нашего телеканала", и лишь после общественного резонанса по поводу фальсификации факта присутствия беглого чиновника в студии телеканал разослал оправдание: "В нашей студии Азаров находился при помощи системы дополненной реальности и трекинга для ввода виртуального объекта в реальную студию". Проще говоря, Азаров был не в Киеве, а сидел в неизвестном месте на фоне хромакей, при этом ни редакция, ни сам бывший премьер не сообщили о реальном месте пребывания, а канал изображал его присутствие в киевской студии.

Использование новых технологий подделки видео трансформирует смысл доказательств в журналистике, в политических коммуникациях, в области уголовного правосудия и национальной безопасности. Безусловно, выявить фальшивку можно, но дело в том, что подделки нового типа появляются раньше алгоритмов их распознавания. Именно поэтому еще больше возрастает роль медиа в процессе проверки входящей информации.

В украинскую политику искусственный интеллект пока не проник. Как выразилась одна из главных редакторов популярного в стране медиа: "У наших пока руки из нижних плеч, но они быстро научатся". Как научились, например, создавать нишевые информационные каналы, которые стали "фишкой" нынешней избирательной кампании: у каждого штаба свой телеканал, продвигающий в общественную повестку нужные сообщения, корректирующие повествование и восприятие реальности в Украине. Один из политиков, желавший открыть еще один канал, жаловался, что не смог этого сделать, ибо: "Все специалисты на рынке заняты, и мы столкнулись с кадровым дефицитом". То есть спрос на телевизионную коррекцию реальности настолько велик, что свободных профессионалов уже нет.

Научились штабы и таргетировать рекламу в социальных сетях. В последние дни марта 2019 года, перед выборами президента Украины, стоимость одного взаимодействия с роликами на YouTube колебалась около 20 копеек, в то время как в межвыборный период при грамотном планировании и профессиональной работе таргетолога она составляет 3–5 копеек. А скандал с раскрытием миллионных бюджетов, потраченных кандидатами на антирекламу конкурентов в Facebook, заставляет задуматься о готовности политиков использовать любые методы для предвыборных манипуляций. Так неужели они остановятся перед новыми технологиями, открывающими неограниченные возможности для очернения конкурентов? В это верится с трудом.

Грань между реальностью и виртуальным миром стирается быстро, и все чаще мы уже не можем доверять глазам и ушам. Из моря информации, обрушивающегося на нас ежедневно, мозг быстрее всего выхватывает яркие образы в виде картинок и фрагментов видео, формируя наше восприятие действительности и политические предпочтения. Это значит, что технологии, направленные на искажение мультимедийного контента, становятся новым видом гонки вооружений.

Войти с помощью Google

Войти с помощью Google